SEO의 관문 Robots.txt 역할과 사용 방법

목차

1. 소개

Robots.txt 파일은 검색 엔진 크롤러에게 웹 사이트의 페이지 인덱싱 규칙을 알려주는 중요한 파일입니다. 이 기사에서는 SEO에 관한 Robots.txt 파일의 역할과 사용 방법에 대해 알아보겠습니다.

2. Robots.txt의 역할

Robots.txt 파일은 다음과 같은 역할을 수행합니다:

- 검색 엔진 크롤러에게 웹 사이트의 페이지 인덱싱 규칙을 알려줍니다.

- 특정 디렉토리나 파일을 크롤링하지 않도록 지시할 수 있습니다.

- 크롤러가 접근할 수 있는 페이지를 제한하거나 허용할 수 있습니다.

- 검색 크롤러에 의한 과부하 방지를 합니다.

- 사이트 맵 위치 전달 하여 웹마스터도구에 등록되지 않은 다양한 검색엔진에게 위치를 알려줄 수 있습니다.

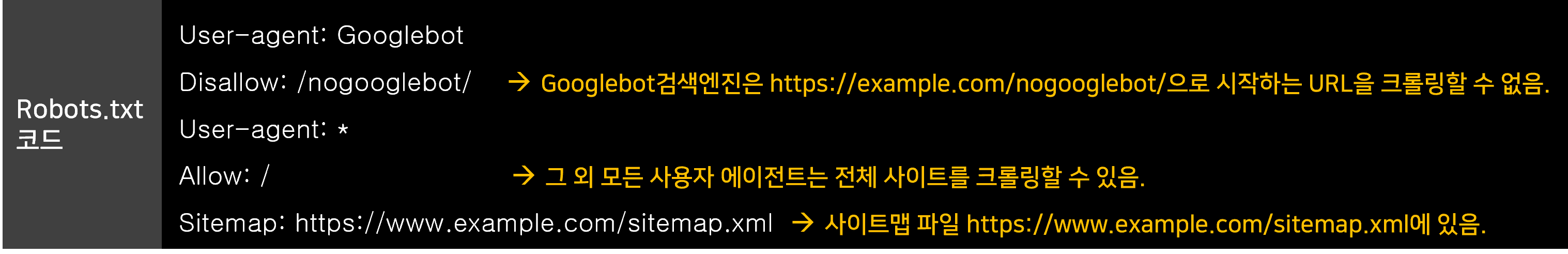

3. Robots.txt 사용 방법

Robots.txt 파일의 사용 방법은 다음과 같습니다:

- 파일을 웹 사이트의 루트 디렉토리에 저장합니다.

- Allow 및 Disallow 지시문을 사용하여 특정 경로나 파일을 크롤러에게 허용하거나 제한합니다.

- User-agent 지시문을 사용하여 특정 크롤러에 대한 규칙을 설정할 수 있습니다.

- Sitemap 지시문을 사용하여 사이트맵의 위치를 알려줄 수 있습니다.

4. 사례 연구 및 통계

Robots.txt 파일의 사용이 SEO에 미치는 영향을 확인하기 위해 다음과 같은 사례 연구와 통계를 살펴볼 수 있습니다:

- 사례 연구 1: 회사 X는 Robots.txt 파일을 사용하여 중요한 페이지를 크롤러에게 허용함으로써 검색 엔진에서의 가시성을 향상시켰습니다.

- 사례 연구 2: 웹 사이트 Y는 Robots.txt 파일을 사용하여 크롤러가 접근할 수 없는 디렉토리를 설정함으로써 중복 컨텐츠 문제를 해결하고 검색 엔진에서의 순위를 향상시켰습니다.

- 통계 1: Robots.txt 파일을 사용하는 웹 사이트는 검색 엔진 크롤러의 효율성을 높일 수 있으며, 이는 검색 엔진에서의 노출과 트래픽 증가로 이어질 수 있습니다.

- 통계 2: 올바르게 구성된 Robots.txt 파일은 웹 사이트의 SEO 성과를 향상시킬 수 있습니다. 특히 중복 컨텐츠와 같은 문제를 예방할 수 있습니다.

5. 결론

Robots.txt 파일은 SEO에 있어서 중요한 역할을 수행합니다. 올바르게 구성된 Robots.txt 파일은 검색 엔진 크롤러가 웹 사이트를 효율적으로 크롤링하고 인덱싱할 수 있도록 도와줍니다. 사례 연구와 통계를 통해 Robots.txt 파일의 사용 방법과 이점을 확인하였으며, 웹 사이트의 SEO를 개선하기 위해 Robots.txt 파일을 적절하게 활용하는 것이 권장됩니다.

자주 묻는 질문

Robots.txt 파일이란 무엇인가요?

Robots.txt 파일은 웹사이트의 특정 페이지나 디렉토리에 대해 검색 엔진 크롤러의 접근을 허용하거나 제한하는 역할을 하는 파일입니다. 이를 통해 웹사이트의 크롤링 방식을 제어할 수 있습니다.

Robots.txt 파일은 SEO에 어떻게 영향을 미치나요?

Robots.txt 파일은 검색 엔진 크롤러가 인덱싱할 페이지를 지정하여 SEO 성과를 높이는 데 도움을 줍니다. 잘 구성된 Robots.txt 파일은 중복 콘텐츠 문제를 해결하고, 크롤링 효율성을 높일 수 있습니다.

Robots.txt 파일을 어떻게 설정하나요?

Robots.txt 파일은 웹사이트의 루트 디렉토리에 위치하며, Allow와 Disallow 지시문을 사용해 특정 페이지나 디렉토리의 접근을 허용하거나 제한할 수 있습니다. 특정 크롤러에 대한 규칙도 설정할 수 있습니다.

Robots.txt 파일에 사이트맵을 어떻게 추가하나요?

Robots.txt 파일에 Sitemap: [사이트맵 URL] 지시문을 추가하여 검색 엔진 크롤러에게 사이트맵의 위치를 알려줄 수 있습니다. 이를 통해 크롤러가 사이트의 구조를 더 잘 이해하게 됩니다.

Robots.txt 파일이 잘못 설정되면 어떻게 되나요?

잘못된 Robots.txt 설정은 중요한 페이지가 검색엔진에 크롤링되지 않거나, 반대로 인덱싱되지 말아야 할 페이지가 인덱싱되는 문제가 발생할 수 있습니다. 이는 SEO 성과에 부정적인 영향을 미칠 수 있습니다.

Robots.txt 파일을 사용하는 이유는 무엇인가요?

Robots.txt 파일은 검색 엔진 크롤러의 과부하를 방지하고, 중요하지 않거나 민감한 콘텐츠를 크롤링하지 않도록 설정하여 웹사이트의 크롤링 효율성을 높이기 위해 사용됩니다.

Robots.txt 파일로 검색 엔진 크롤러를 특정 페이지에서 차단할 수 있나요?

네, Disallow 지시문을 사용해 특정 페이지나 디렉토리의 크롤링을 차단할 수 있습니다. 이를 통해 검색 엔진이 인덱싱하지 않길 원하는 페이지를 차단할 수 있습니다.